Fino a che punto possiamo fidarci delle decisioni automatizzate

Selezionare chi assumere, valutare gli avanzamenti di carriera, decidere chi confermare e chi licenziare. Filtrare domande di ammissione agli studi universitari. Stabilire a chi concedere prestiti o assicurazioni, a chi offrire le offerte commerciali migliori o quelle meno vantaggiose. Allocare le risorse sanitarie, scegliere a chi riservarle con priorità. Gli algoritmi dei sistemi automatizzati di decisione sono ormai presenti nella vita quotidiana.

La raccolta su larga scala di dati in formato digitale procede sempre più pervasiva, insieme alla diffusione di tecnologie in grado di utilizzarli per generare modelli e previsioni dei comportamenti sociali. È un cambiamento in atto, ancora poco compreso e regolamentato, che rischia di influenzare, in modo non sempre consapevole e con conseguenze difficilmente prevedibili, i processi decisionali che generano giudizi sulle persone, condizionando il loro quadro di opportunità, in momenti cruciali del loro percorso di vita.

Si tratta di soluzioni tecnologiche che esercitano un impatto radicale su interi settori economici e sociali, dalla logistica ai trasporti, dal commercio al dettaglio alla pubblicità, dal sistema sanitario alle politiche sociali, fino alla governance pubblica e ai processi della democrazia.

Influenza diretta sulla comunità e sulla vita delle persone che risulta sempre più problematica per la presenza di fattori di distorsione e di pregiudizio all’interno dei algoritmi. Negli ultimi anni, la ricerca ha mostrato chiaramente come i bias presenti negli algoritmi non siano più solo una preoccupazione teorica ma operino in modo fattivo già in diversi contesti applicativi. Joy Buolamwini, ricercatrice del MIT, ha evidenziato come sistemi software di riconoscimento facciale oggi in commercio presentino bias che mettono in atto effetti discriminatori in funzione del colore della pelle e del genere [1]. Che il fenomeno sia già diffuso in contesti reali lo dimostra anche la decisione di Amazon di interrompere l’utilizzo di un algoritmo di reclutamento dopo aver scoperto la presenza di un pregiudizio di genere.

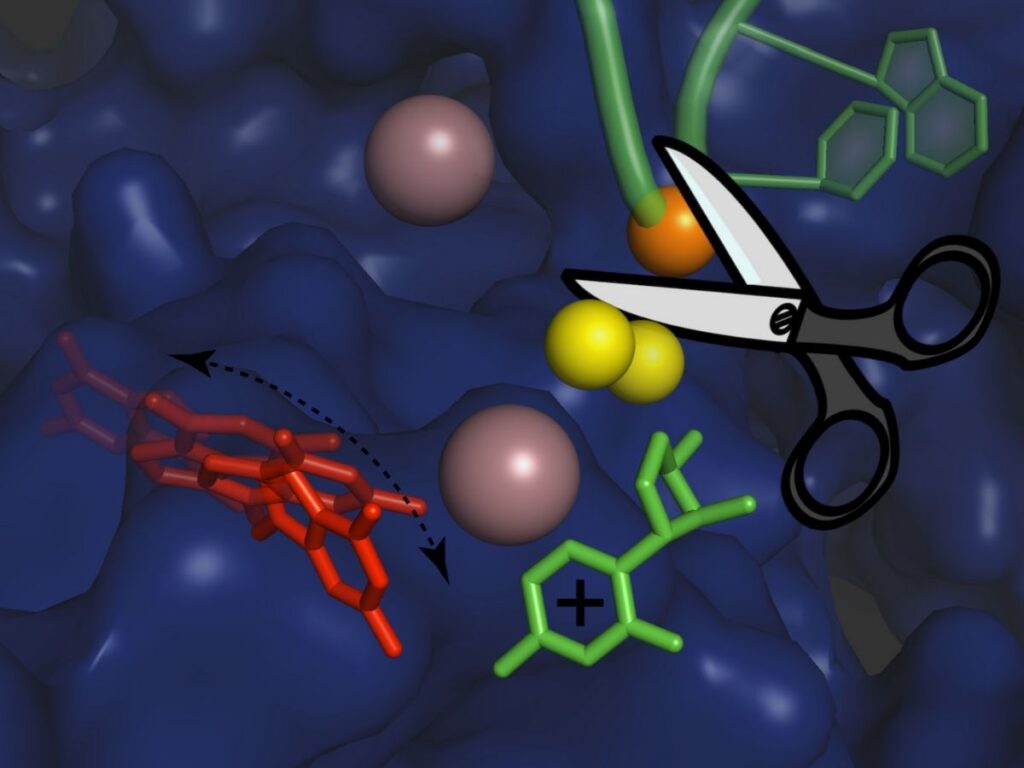

I bias all’interno degli algoritmi decisionali esistono ma non riflettono necessariamente le intenzioni di programmatori. Le reti neurali integrano distorsioni acquisendole dai data set e dalle informazioni adottate durante la fase di addestramento. Spesso il pregiudizio deriva da difetti presenti nei dati utilizzati il training, perché

insufficienti o talvolta perché più rappresentativi di alcuni gruppi di persone rispetto ad altri. Tuttavia la distorsione può insinuarsi in tutto il ciclo di vita della progettazione, nel modo in cui il problema e il supporto alle decisioni vengono definiti e impostati, ma anche nelle fasi successive, per una mancata verifica degli effetti distorsivi nelle fasi di test e nell’operatività sul campo.

D’altronde, gli stessi progettisti hanno spesso difficoltà a spiegare come gli algoritmi operino nel dettaglio, parte del funzionamento è riconducibile al modello di una “black box”. Questa mancanza di trasparenza si traduce nel fatto inaccettabile che le persone che subiscono una discriminazione faticano a comprenderne il perché. Esiste quindi una necessità di trasparenza a cui sarebbe bene affiancare un “diritto alla spiegazione”, concetto già introdotto nel GDPR, regolamento generale sulla protezione dei dati dell’Unione europea, sia pure in forma non propriamente vincolante.

Come bene chiarisce, Paolo Benanti nel suo articolo “Algoritmo equo? Prospettive sul tema”, gli algoritmi potrebbero offrire alle persone “spiegazioni controfattuali”, ma anche la possibilità di ricorso. Spiegazioni controfattuali che aiutino a rivelare meglio il percorso decisionale, indicando il cambiamento minimo è necessario fare per ottenere un esito positivo. Se viene negato l’accesso a un credito, perché non indicare anche cosa occorre fare per invertire la decisione? E’ un modo per verificare se l’algoritmo è soggetto a distorsioni e pregiudizi.

La possibilità di fare ricorso rendere possibile alle persone di modificare l’esito del processo decisionale. Esiste un differenza, sottolinea Benanti, “tra una domanda di lavoro negata che ha come esito di consigliarti di ottenere una laurea per ottenere l’impiego, rispetto a una che dice che è necessario modificare il sesso o l’età per avere quel risultato” [2].

Se è vero che un algoritmo, come sostiene Jon Kleinberg della Cornell University, “non ha altra scelta che essere premeditato” [3], è evidente che accanto al rischio di replicare e persino amplificare i pregiudizi umani, al tempo stesso un algoritmo può essere strumento di contrasto dei bias sociali, operando non solo a posteriori, ma anche in ottica preventiva durante l’intera fase di progettazione.

E’ questa una questione cruciale del dibattito in corso. Come conciliare la diffusione una tecnologia che promette livelli di efficacia ed efficienza mai raggiunti prima, con la necessità di garantire responsabilità, equità e massima trasparenza nel suo utilizzo? Richiesta di trasparenza che confrontarsi anche con l’intento delle aziende di non rivelare aspetti del software proprietario, ritenuti segreti commerciali a tutela degli investimenti effettuati.

La proposta di un possibile quadro di riferimento, definito “framework for algorithmic hygiene”, è stata descritta in un recente articolo pubblicato sul sito della Brookings Institution, da Nicol Turner Lee, Paul Resnick e Genie Barton [3]. Oltre all’approfondimento delle questioni relative alla responsabilità e all’equità della progettazione di algoritmi nel supporto dei processi decisionali, il lavoro ha il merito di indicare diversi approcci al rilevamento dei bias e un quadro dettagliato di strategie di contrasto e di attenuazione.

Si ipotizza un’azione articolata su più fronti. Innanzitutto si evidenzia la necessità di aggiornare costantemente la normativa e le politiche in funzione degli sviluppi tecnologici. Si propone l’utilizzo dei cosiddetti “regulatory sandbox” e di “safe harbor” per favorire la sperimentazione di processi anti-bias e l’utilizzo di informazioni sensibili al fine di rilevare e ridurre pregiudizi e distorsioni. In sinergia con questa strategia di regolamentazione aperta, si prospetta la diffusione di buone pratiche di autoregolamentazione, l’adozione di dichiarazioni di impatto pregiudizievole, l’utilizzo di principi di progettazione più inclusivi basati su team di lavoro più multidisciplinari e al tempo stesso meglio rappresentativi dei gruppi sociali più a rischio di discriminazione. Se in generale, un ruolo innovativo può essere svolto dall’”Ethics by Design”, più nello specifico, è utile affidarsi a un approccio “Diversity-in-Design”, dove centrale risulta il ruolo della diversità, non solo all’interno dei team di lavoro, ma anche nei Data Set necessari per l’addestramento delle reti neurali e nell’adozione di criteri di sensibilità multiculturale all’interno degli obiettivi e dei processi decisionali.

Un passo in questa direzione è stato condotto dall’Istituto AI Now della New York University con la messa a punto di un modello per la realizzazione di valutazioni di impatto degli algoritmi (AIA, Algorithmic Impact Assessments) [4].

Resta evidente cha la dichiarazione di impatto pregiudizievole non può essere una soluzione esaustiva. Il processo di valutazione deve proseguire durante l’intero ciclo di operatività dei processi decisionali. A tal fine, può essere utile adottare modelli di feedback costanti che prevedano il coinvolgimento fattivo di più soggetti: dagli utenti finali agli organi di controllo istituzionali, da figure esperte indipendenti fino all’ampio ventaglio di realtà associative che meglio di altri possono dare voce al fattore di diversità che tanto critico si è rivelato nello sviluppo di questa tecnologia.

Diversi sono oggi i percorsi istituzionali che muovono, sia pure con approcci diversificati, verso la definizione di un quadro di riferimento. Dall’Unione Europea che ha recentemente prodotto le “Ethics guidelines for trustworthy AI”, dove delinea sette principi di governance [5], all’iniziativa promossa dall’OCSE “Principi Ocse sull’Intelligenza Artificiale”, prime linee guida intergovernative sulle politiche relative all’intelligenza artificiale, firmate di recente da 42 Paesi [6].

Accanto a queste iniziative, resta sullo sfondo generale, come un fattore imprescindibile, la necessità, sempre più urgente e non procastinabile, di alfabetizzare i consumatori e i cittadini all’uso degli algoritmi decisionali nella vita quotidiana e nell’esercizio dei propri diritti. Nella consapevolezza che occorre aumentare il coinvolgimento umano nella progettazione e nel monitoraggio degli algoritmi dei sistemi decisionali automatizzati, per attenuarne le distorsioni ma anche per riaffermare il principio che essi possano operare per integrare il giudizio umano e mai per sostituirlo completamente.

___

RIFERIMENTI

[1] Larry Hardesty. “Study finds gender and skin-type bias in commercial artificial-intelligence systems”

http://news.mit.edu/2018/study-finds-gender-skin-type-bias-artificial-intelligence-systems-0212

[2] Paolo Benanti. “Algoritmo equo? Prospettive sul tema”

https://www.paolobenanti.com/single-post/2018/10/15/Algoritmo-equo

[3] Nicol Turner Lee, Paul Resnick e Genie Barton. “Algorithmic bias detection and mitigation: Best practices and policies to reduce consumer harms”

[4] Dillon Reisman, Jason Schultz, Kate Crawford e Meredith Whittaker. “Algorithmic Impact Assessments: A Practical Framework for Public Agency Accountability.”

[5] Raffaele Maurici. “Verso il codice etico europeo dell’intelligenza artificiale”

https://opentalk.iit.it/verso-il-codice-etico-europeo-dellintelligenza-artificiale/

[6] Recommendation of the Council on OECD Legal Instruments Artificial Intelligence.